大型语言模型(LLM)正日趋成熟,已足以驱动复杂的 AI 代理。它们驱动的代理并非自由放任、类 AGI 的代理,而是专注于特定用例和特定重点的垂直领域特定代理。过去一年推出的这些 AI 代理的例子包括 Replit 的编码代理、Elastic 的安全助手 和 Uber 的开发者生产力平台。

这些代理中很大一部分依赖于大型闭源模型。在企业环境中部署代理时,这种方法会带来一些挑战。这些挑战包括大量的推理成本、影响实时性能的显著延迟,以及关于数据隐私和合规性的担忧,尤其是在处理敏感信息时。

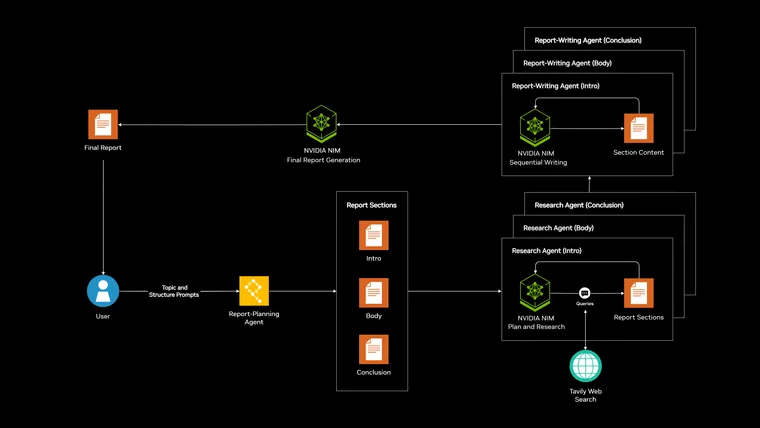

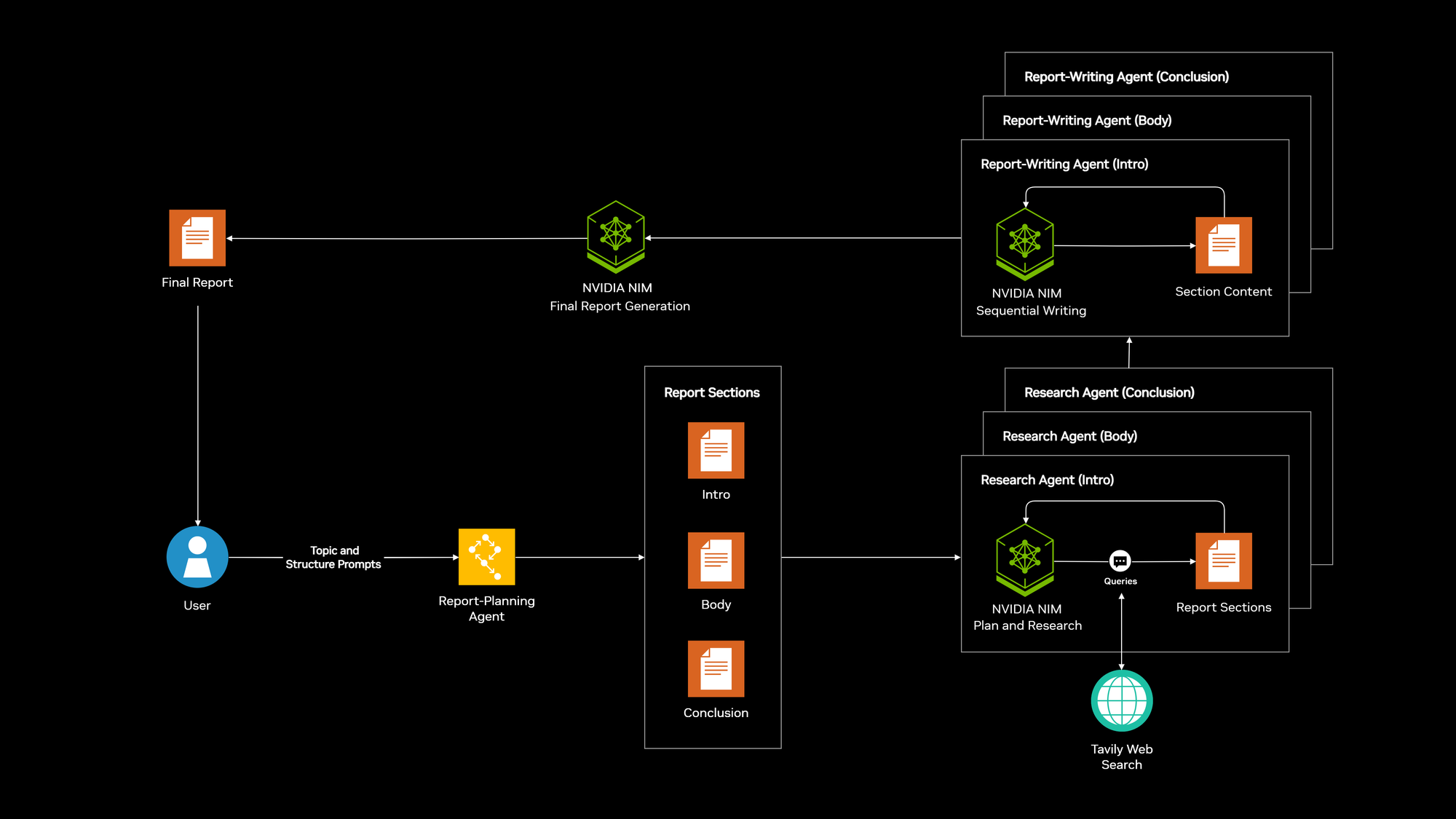

NVIDIA NIM 微服务是 NVIDIA AI Enterprise 的一部分,有助于解决这些问题。我们很高兴与 NVIDIA 合作发布一个新的 AI 代理技术蓝图,称为结构化报告生成。通过使用 LangGraph,该蓝图允许用户定义主题并指定大纲,以指导代理在网络上搜索相关信息,从而以请求的结构化格式返回报告。

“LangChain 基于 NVIDIA AI Enterprise 和 NVIDIA NIM 微服务构建的结构化报告生成 AI 蓝图,使企业能够创建定制的、高性能的 AI 代理,这些代理不仅解决了部署和安全方面的关键挑战,而且还充分利用了开源 LLM 的潜力,实现变革性的业务成果,”NVIDIA 企业 AI 软件产品副总裁 Justin Boitano 表示。

关键链接

技术堆栈

该蓝图构建于 LangGraph 和 NVIDIA AI Enterprise 平台之上,由以下部分组成:

* NVIDIA NIM: 提供了一个便携、安全的平台,用于在任何地方(云、数据中心或工作站)运行优化模型,具有成本效益、高吞吐量和低延迟。

* 开放模型,包括 Mistral AI 和 Meta Llama: 允许更大的控制和定制,并有助于解决数据隐私问题,NVIDIA NIM 通过开箱即用支持这些模型。

* LangGraph:能够构建具有精细控制认知架构的复杂代理工作流程,从而可以使用较小的模型构建高性能代理。

* LangGraph 平台:促进代理的部署,可以选择在本地运行以增强安全性和控制。

* LangSmith:提供全面的监控和测试功能,也可以在本地部署,从而可以对代理进行严格的评估和调试。

详细分解

通过利用 NIM 微服务支持的社区模型,我们使企业能够在任何地方(云或数据中心)部署其 AI 代理,减少对第三方托管推理的依赖,并显著降低成本。NIM 微服务的优化特性有助于显著加快推理时间。

NVIDIA NIM 支持的开放模型,如 Mistral AI 模型或 Meta 的 Llama 模型系列,允许更高的透明度和定制性。这对于需要完全控制其数据和模型行为的企业至关重要。开源模型还允许针对特定任务进行微调,进一步提高性能并降低成本。

LangGraph 为构建复杂的多步骤代理工作流程提供了结构化框架。它允许开发人员定义其代理的认知架构,使其能够构建复杂的推理和决策过程。这种程度的控制对于构建能够使用更小、更高效的模型执行复杂任务的代理至关重要。

LangGraph 平台简化了代理的部署。其在本地运行的能力确保了敏感数据保留在组织的基础设施内,有助于解决关键的数据隐私问题。

LangSmith 提供了监控和测试代理的必要工具,使团队能够跟踪性能、识别瓶颈并确保其代理的可靠性。本地部署选项允许完全控制用于测试和监控的数据。

结论

由 LangChain 和 NVIDIA 共同创建的结构化报告生成 AI 蓝图将帮助组织释放 AI 代理的全部潜力。这种强大的组合能够开发安全、经济高效且高性能的代理,以满足特定的企业需求,超越闭源解决方案的局限性。通过优先考虑控制、定制和性能的解决方案,拥抱 AI 的未来。

关键链接