编者按: 这篇文章是与 TitanML 团队合作撰写的。他们 NLP 开发平台与 LangChain 的集成使法学硕士的推理变得超级容易!

挑战

随着过去一年中许多开源大型语言模型的发布,开发人员越来越渴望加入潮流并部署自己的法学硕士。然而,如果没有专门的知识,尝试在自己的硬件上部署法学硕士的开发人员可能会面临意想不到的技术难题。最近对强大 GPU 的争夺也使得更难获得足够的 GPU 分配来以所需的延迟和规模部署最佳模型。

开发人员面临着一个令人不快的选择:要么因在模型大小和质量上妥协而导致应用程序不尽如人意,要么因手动优化和依赖昂贵的 GPU 而导致部署成本高昂,更不用说浪费时间处理枯燥且一次性的技术怪癖了。

Titan Takeoff 服务器

话虽如此,在本地部署您自己的模型不必困难和令人沮丧。 Titan Takeoff 服务器为本地部署开源大型语言模型 (LLM) 提供了一个简单的解决方案,即使在内存受限的 CPU 上也是如此。有了它,用户可以获得本地推理的好处——降低延迟、增强数据安全性、长期节省成本以及在模型定制和集成方面无与伦比的灵活性,而无需额外的复杂性,更不用说能够在内存受限的硬件上部署更大、更强大的模型。

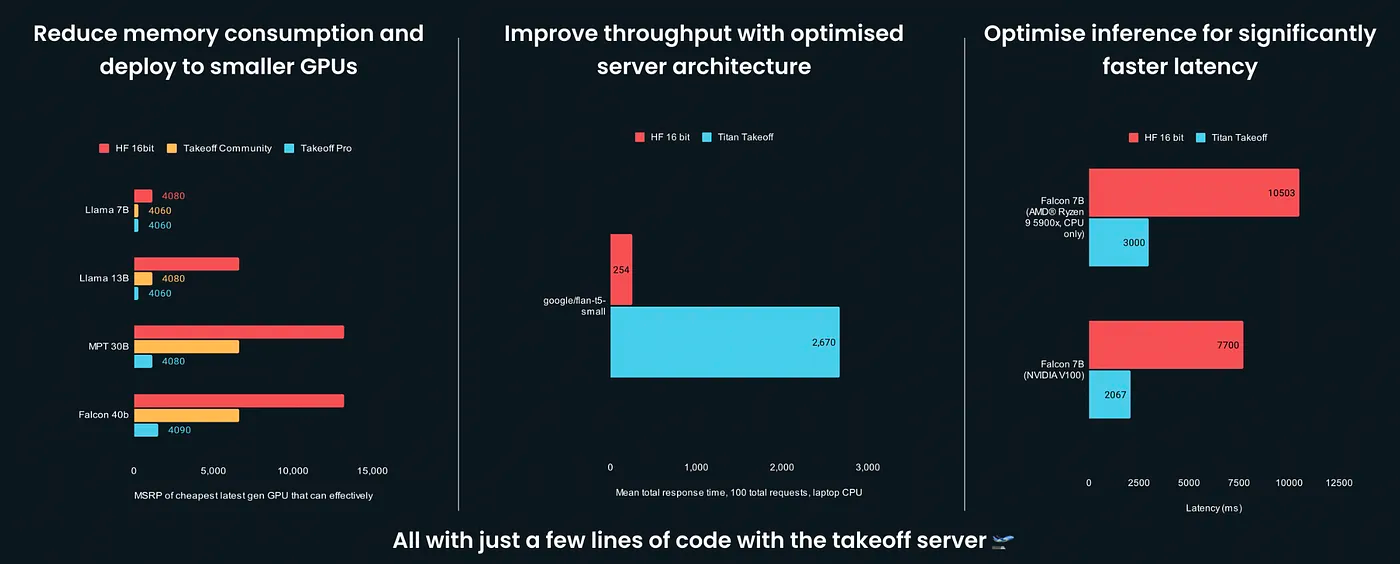

凭借其闪电般的推理速度以及对低成本、易于获得的设备的支持,Titan Takeoff 服务器适用于需要不断部署、测试和改进其法学硕士的开发人员。通过使用最先进的内存压缩技术,与基础模型实现相比,Titan Takeoff 服务器在吞吐量方面提高了 10 倍,延迟方面提高了 3-4 倍,并通过使用更小的 GPU 节省了 4-20 倍的成本。在这个控制和效率至上的时代,Titan Takeoff 服务器是部署和推理法学硕士的最佳解决方案。

与 LangChain 无缝集成

随着 Titan Takeoff 最近集成到 LangChain 中,用户将能够以最少的设置和编码开销来推理他们的法学硕士。您可以观看一个简短的演示,了解如何将 LangChain 集成与 Titan Takeoff 结合使用

以下是如何通过这些简单的步骤开始部署和推理您的法学硕士。安装 Iris CLI,这将允许您运行 Titan Takeoff 服务器

pip install titan-iris

启动 Takeoff 服务器,指定 HuggingFace 上的模型名称,以及您是否使用 GPU 的设备。这将从 HuggingFace 服务器拉取模型,允许您在本地推理模型。

iris takeoff --model tiiuae/falcon-7b-instruct --device cuda

Takeoff 服务器现在已准备就绪。然后,您可以通过为其提供自定义端口(如果未在默认端口 8000 上运行 Takeoff 服务器)或其他生成参数(例如温度)来初始化 LLM 对象。还可以选择指定流式传输标志。

llm = TitanTakeoff(port=5000, temperature=0.8, streaming=True)output = llm("What is the weather in London in August?")print(output)

# Output: The weather in London in August can vary, with some sunny days and occasional rain showers. The average temperature is around 20-25°C (68-77°F).通过这些简单的步骤,您已经使用在本地机器上运行的 Titan Takeoff 服务器对法学硕士进行了首次推理调用。有关使用 Takeoff x LangChain 集成的更多示例,请查看我们的指南此处。

结论

Titan 的 Takeoff 服务器与 LangChain 的集成标志着语言模型驱动应用程序的开发和部署进入了一个变革阶段。随着开发人员和企业寻求更快、更高效且更经济高效的方式来利用法学硕士的功能,像这样的解决方案为更智能、更无缝和超强能力的未来铺平了道路。

关于 TitanML

TitanML 是一个 NLP 开发平台和服务,专注于法学硕士的可部署性。我们的 Takeoff 服务器是一个超优化的法学硕士推理服务器,它可以“正常工作”,使其成为在本地试验和部署法学硕士的最快和最简单的方法。

我们的文档和Discord 社区在这里为您提供支持。