LangChain 产品系列迎来新成员!LangGraph Cloud 今天迈出了第一步——继续阅读,了解它为何对代理工作流程如此有趣,它与 LangGraph 有何不同,以及如何注册测试版。此外,请在下方获取所有常规集成和社区更新。

产品更新

重点介绍 LangChain、LangSmith 和 LangGraph 的最新产品更新和新闻

☁️ LangGraph Cloud:大规模部署,仔细监控,大胆迭代

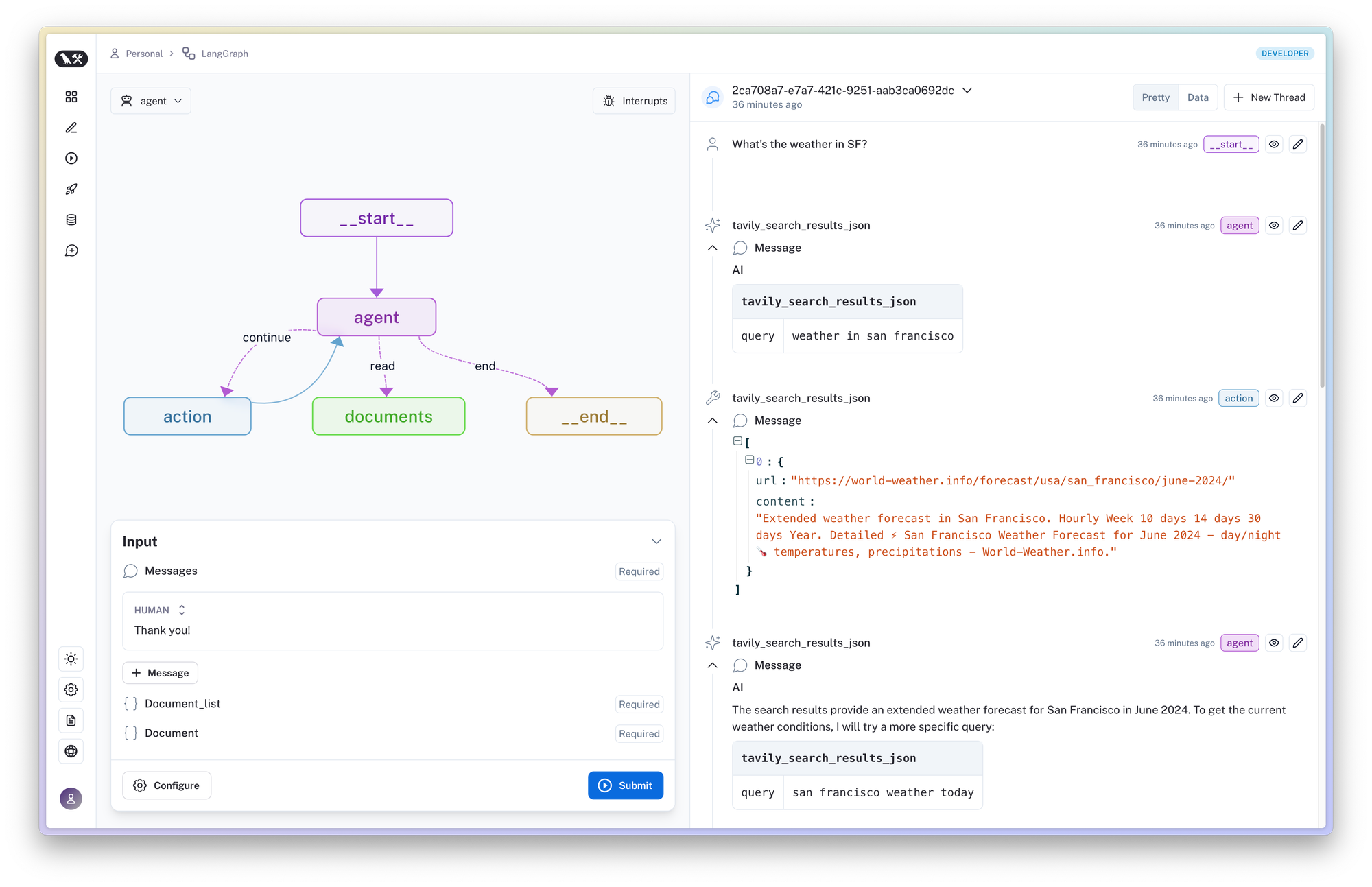

LangGraph Cloud 现已进入封闭测试阶段,为 LangGraph 代理提供可扩展、容错的部署。一键部署,并在 LangSmith 中获得集成的跟踪和监控体验。LangGraph Cloud 还包括一个类似于游乐场的全新工作室,用于调试代理故障模式和快速迭代

这是在我们最新稳定版 LangGraph v0.1 的基础上构建的,它支持人工参与循环协作(例如,人工可以批准或编辑代理操作)和一流的流式传输支持,让您在构建代理时拥有更多控制权。

立即加入等候名单,体验 LangGraph Cloud。如需了解更多信息,请阅读我们的 博客文章公告。

🔁 LangSmith 中的自我改进 LLM 评估器

使用“LLM 作为评判者”是一种流行的 LLM 应用程序输出评分方法。这涉及将生成的输出传递给一个单独的 LLM,并要求它对输出进行评判。但是,要确保“LLM 作为评判者”表现良好,需要另一轮提示工程。谁来评估评估者?😵💫

LangSmith 通过允许用户对 LLM 评估器反馈进行更正来解决这个问题,这些更正随后被存储为少量样本,用于调整/改进“LLM 作为评判者”。无需手动调整提示即可改进未来的评估,确保更准确的测试。在我们的博客中了解更多信息。

LangSmith 中的更多内容

🥷 LangSmith 中的 PII 遮蔽

通过指定正则表达式列表或为提取的字符串值提供转换方法来创建匿名器。阅读文档。

🛝 LangSmith Playground 中的自定义模型

部署模型服务器后,可以通过为聊天风格模型或指令风格模型选择ChatCustomModel或CustomModel提供程序,在 LangSmith Playground 中使用它。请参阅文档。

🧷 保存提示时存储模型和配置

在 LangSmith 中保存提示时,模型及其配置也将被存储。您不再需要每次打开提示时都在 Playground 设置中重置您的偏好,这使得测试提示更加容易。

LangChain

🪄 用一行代码初始化任何模型

借助 LangChain Python 中的通用模型初始化器,您可以使用任何常见的聊天模型,而无需记住不同的导入路径和类名。请参阅操作指南。

✂️ 使用转换器实用程序修剪消息

使用新的trim_messages实用程序轻松修剪、合并和过滤消息——这对于状态化或复杂应用程序(例如,在 LangGraph 中构建的应用程序)特别有用。请参阅操作指南。

即将举行的活动

在下个月的以下线下活动中与 LangChain 爱好者、员工和热心的 AI 应用程序构建者见面

🐻 7 月 10 日(德克萨斯州奥斯汀):奥斯汀 LangChain 用户组见面会。想快速入门 LangChain 101,听取有关 LangChain 的实用技巧,或查看我们最新 NVIDIA 竞赛中的优秀项目?那就来参加我们在奥斯汀的聚会,学习并结识其他 AI 爱好者。在此注册。

合作与集成

我们 💚 帮助用户通过使用我们的集成来利用生态系统中的合作伙伴功能

Anthropic Sonnet 3.5 集成

借助 Anthropic 提供的更好、更快、更便宜的模型,您可以尝试(Python 文档)(JavaScript 文档)

使用 Fireworks 的 Firefunction-v2 进行微调工具调用

借助基于 Llama 3-70b 构建的新开放权重模型 Firefunction-v2,您可以轻松进行工具调用、构建代理和进行基准测试。查看视频和手册。

使用 llama.cpp 进行完全本地函数调用

我们的 llama.cpp 集成现在支持工具调用和结构化输出。在此视频中了解如何将其与微调的 8b 参数 llama3 模型一起使用。

Vocode 与 LangChain 集成

您现在可以使用 LangChain 和 Vocode 创建自定义代理,用于构建基于语音的 LLM 应用程序。阅读文档。

感谢 Redpoint 将 LangChain 列入其 2024 年InfraRed 100 强!

使用 LangChain

人们如何使用 LangChain、LangSmith 或 LangGraph 构建高质量、高精度的 LLM 应用程序的真实用例和示例——即使是在生产环境中

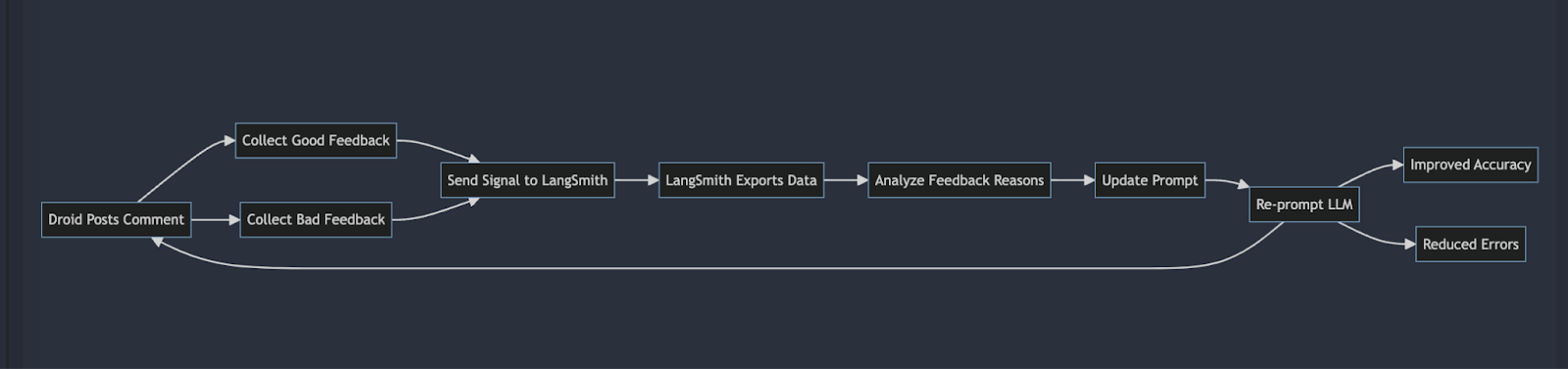

优化和测试 LLM

阅读我们的案例研究,了解Factory 如何借助 LangSmith 将迭代速度提高 2 倍。Eno Reyes(Factory 首席技术官)解释了他们如何利用 LangSmith 深入的 observability 来加速软件开发。了解他们如何自动化其 Droids 的反馈循环,在保持企业级安全性的同时达到最先进的性能基准。

除了获得可靠的反馈外,了解如何在您的 AI 工作流程上运行标准化评估也至关重要。Adam Lucek(思科技术创新专家)在他的LLM 和 AI 基准测试视频和代码中对此进行了介绍。

代理

将 LLM 驱动的自动化代理投入生产具有挑战性。借助改进的工具调用 LLM 和代理编排工具,开发人员需要系统化的方法来评估代理性能。在 Lance Martin 的这个由 3 部分组成的视频系列中,了解如何评估代理的端到端性能(视频 1)、代理的单个步骤(视频 2)和代理步骤轨迹(视频 3)。

我们的首席执行官 Harrison 也在红杉资本的最新一期“Training Data”节目中谈到了代理。什么是代理?LLM 领域中代理的过去/现在/未来是什么?这些问题(以及更多)都得到了讨论——在Spotify或Apple Podcast上收听。

以及更多代理实际应用的示例

- Eden Marco(谷歌云 LLM 专家)提供的使用 LangGraph 和 Mistral AI 完成客户验证流程的视频和代码

- David Cannan(MinIO DevOps)撰写的构建和部署 MinIO 驱动的 LangChain 代理 API博客文章

- James Briggs(Aurelio AI 创始人)提供的LangGraph 101:构建代理

- Moritz Glauner(数据科学主管)和 Lyon Schulz(数据科学家)(贝塔斯曼数据服务公司)提供的使用 LangGraph 和 LangChain 的多代理工作流程

LangChain 新手?以下是一些建议

阅读 Lakshya Agarwal(麦吉尔大学分析师)撰写的这篇LangChain 入门,或观看 Brandon Hancock(Saltbox 全栈工程师)的LangChain 初学者大师班。他的视频通过 20 多个真实的代码示例,演示了如何使用 LangChain 构建强大的 AI 应用程序——从集成聊天模型到创建 RAG 聊天机器人,再到使用链自动化工作流程。

如何关注 Lang Latest 的最新动态?请访问 LangChain 博客 和 YouTube 频道,了解更多产品和内容更新。如有任何其他问题,请发送电子邮件至 support@langchain.dev。

![[Week of 6/24] LangChain Release Notes](/content/images/size/w760/format/webp/2024/06/6-24-Release-Notes---Ghost.png)